1.ES内置分词器

Standard Analyzer - 默认分词器,按词切分,小写处理

Simple Analyzer - 按照非字母切分(符号被过滤), 小写处理

Stop Analyzer - 小写处理,停用词过滤(the,a,is)

Whitespace Analyzer - 按照空格切分,不转小写

Keyword Analyzer - 不分词,直接将输入当作输出

Patter Analyzer - 正则表达式,默认\W+(非字符分割)

Language - 提供了30多种常见语言的分词器

Customer Analyzer 自定义分词器

前面分词器使用的是标准分词器,其对中文分词不是很友好,下面测试分词器效果。

分词结果:

{

"tokens": [

{

"token": "万",

"start_offset": 0,

"end_offset": 1,

"type": "

"position": 0

},

{

"token": "码",

"start_offset": 1,

"end_offset": 2,

"type": "

"position": 1

},

{

"token": "学",

"start_offset": 2,

"end_offset": 3,

"type": "

"position": 2

},

{

"token": "堂",

"start_offset": 3,

"end_offset": 4,

"type": "

"position": 3

},

{

"token": "教",

"start_offset": 4,

"end_offset": 5,

"type": "

"position": 4

},

{

"token": "育",

"start_offset": 5,

"end_offset": 6,

"type": "

"position": 5

}

]

}常见中文分词器有word分词器,庖丁解牛,IK分词器等等。

2. IK分词器的安装

1)下载地址:https://github.com/medcl/elasticsearch-analysis-ik/releases

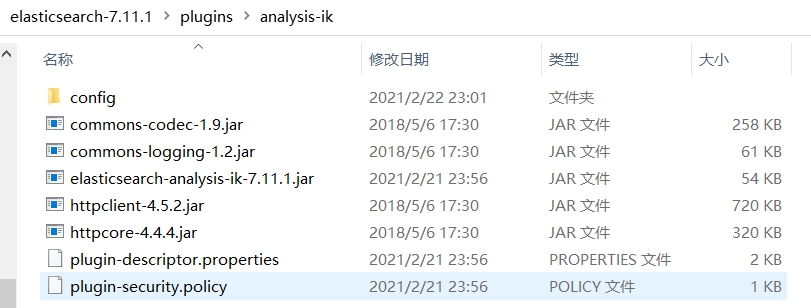

2)下载后解压,文件夹叫analysis-ik,拷贝到elasticsearch主目录下的plugins目录下

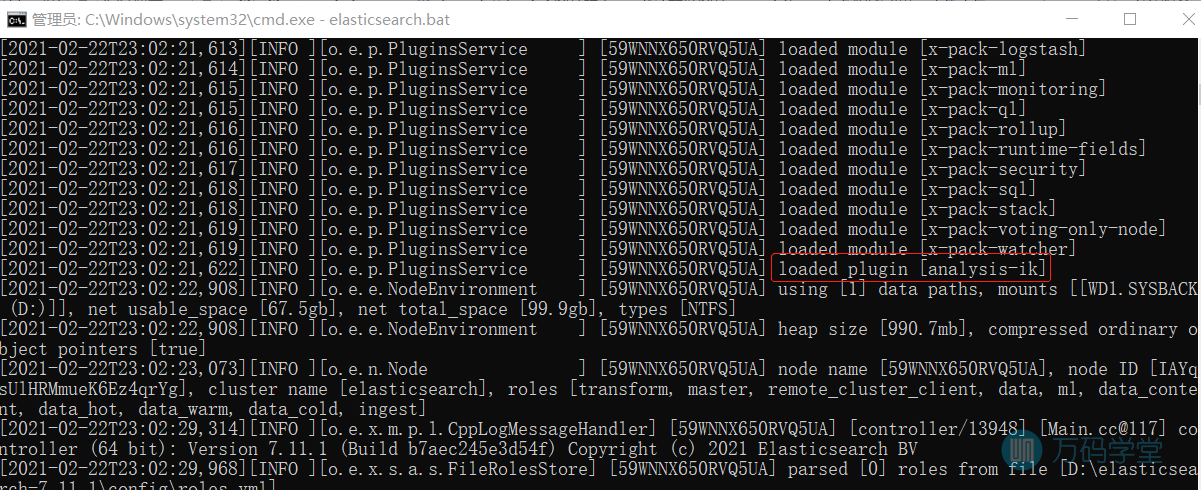

3)重新启动ElasticSearch,即可加载IK分词器

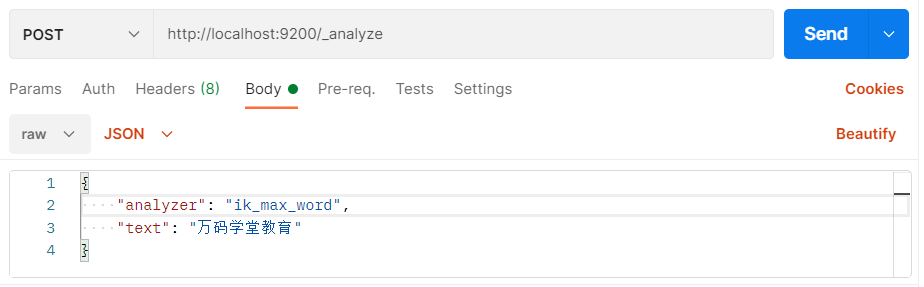

3. 测试IK分词器

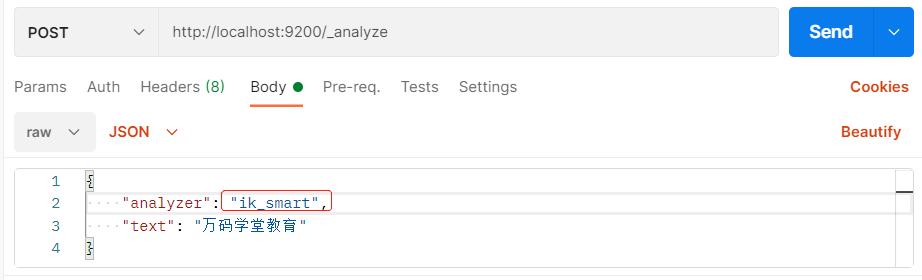

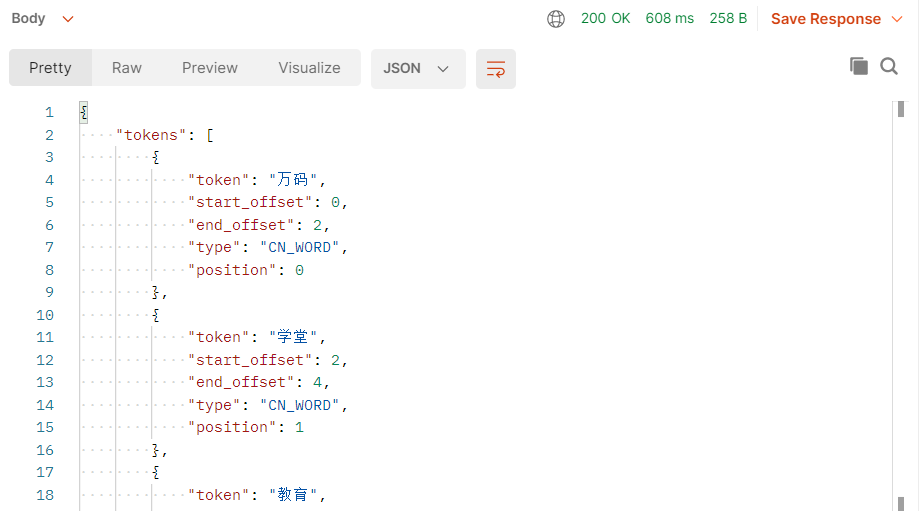

IK提供两种分词ik_smart和ik_max_word,其中ik_smart为最少切分,ik_max_word为最细粒度划分。

3.1. 测试最小切分

3.2. 测试细粒度切分

分词后结果为:万码 万 码 学堂 教育

0条评论

点击登录参与评论